人工智能極大的方便了人們的生活,卻也在某些領域出現偏差,比如美國這個科技始終保持在世界前沿的過渡,其人工智能的應用覆涵的領域非常多,可一些問題漸漸顯露出來,比如其種族這個“享譽”世界的歷史也被延伸到了智能領域。

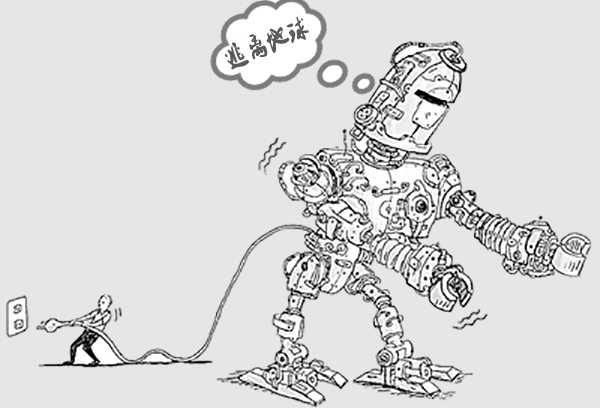

埃隆·馬斯克和 Nick Bostrom 等一些科技界大牛向世界發出了警告:人工智能的存在對人類是一種潛在的威脅,他們把機器智能超越人類智慧的臨界點叫做「奇點(the Singularity)」。人們已為此投入了數百萬美元,并舉辦了大批國際會議。

但這種恐慌情緒讓人們忽視了今天人工智能的真正問題,其實它可能已經在加劇工作場所、家庭、法律及司法系統的不平等。支持「智能」系統運轉的機器學習算法很多在編寫時就被加入了性別和種族歧視以及其它形式的不平等觀念,這決定了我們被分類和接收廣告的方式。

比如去年的那次事件:谷歌有個照片應用,可以自動在電子相冊中把標簽分配到不同照片上,用戶發現它會把黑人的照片歸類為大猩猩。谷歌做出了道歉,表示它并不是故意的。

但類似的錯誤也出現在了尼康的拍攝軟件中,它誤認為亞洲人在照片中眨眼(譯注:其實只是眼睛比較小),還有惠普的網絡相機軟件也很難識別出深色皮膚的人。

美國各地的警察局也配置了類似的數據驅動型風險評估工具,用來預防「潛在的治安犯罪」。在很多城市,包括紐約、洛杉磯、芝加哥和邁阿密,警察局都會用軟件分析量大歷史犯罪數據,預測犯罪熱點區域最可能出現的位置,并據此部署警力。

這個軟件最起碼能持續預測出那些原本就是犯罪高發地的風險,因此警察就會在本來就部署(或大量部署)警力的地方增強安保措施,保證了這些地區逮捕率的提高。在美國,這有可能導致對那些傳統上貧困的非白人居住區的監控警力的增多,而富裕的白人居住區受到的監控就更少。這些預測軟件只擅長分析它們訓練時所用的數據,而這些數據有復雜的歷史。

歧視的歷史可能會延伸到數字平臺上,如果我們對此不聞不問,它們最終就會成為日常算法系統的邏輯的一部分。最近又有一樁丑聞曝出,亞馬遜的當天送達服務在主要的黑人居住區的郵政編碼上是不可用的。而這些被忽視的區域的范圍竟然與 20 世紀中期被貸款歧視所影響的區域基本一致。亞馬遜承諾他們會填補這些空缺,但這也提醒了我們體制不平等對機器智能的影響有多深。

我們要謹慎的設計和訓練機器學習系統,否則未來的人工智能就會被植入根深蒂固的偏見。

【云立方裝飾管理軟件以“裝飾產業轉型升級”為使命,致力改變行業管理現狀,優化各環節資源,建設一個”ERP+APP+電商”的個性化的互聯網生態系統。】